(AI) 인컨텍스트 러닝(In-Context Learning, ICL) 개념 요약

- 인컨텍스트 러닝(In-Context Learning, ICL)은 대규모 언어 모델(LLM, Large Language Model)이 별도의 추가 학습 없이 입력된 프롬프트(Context) 내에서 제공된 정보와 패턴을 학습하여 새로운 문제를 해결하는 방식임

- 일반적인 기계 학습 모델은 사전에 학습된 가중치와 데이터를 기반으로 작동하지만, ICL은 실행 시점에서 제공되는 예시만을 참고하여 추론을 수행함

■ 인컨텍스트 러닝(In-Context Learning)의 핵심 개념

1. 모델 자체를 변경하지 않음

- 기존의 AI 모델은 특정한 작업을 수행하기 위해 훈련 데이터를 활용하여 가중치를 조정하는 반면, ICL은 이미 학습된 모델을 그대로 사용하며, 입력된 프롬프트만을 기반으로 학습과 추론을 수행함

2. 맥락(Context) 기반 학습

- 주어진 맥락 내에서 유사한 패턴을 찾아내고 이를 활용하여 새로운 데이터에 대해 예측을 수행함

3. 제로샷(Zero-shot) 및 퓨샷(Few-shot) 학습 지원

- 제로샷 학습 : 예시를 제공하지 않고 설명만을 통해 문제를 해결하는 방식

- 퓨샷 학습 : 몇 개의 예제를 제공하여 모델이 패턴을 학습하도록 유도하는 방식

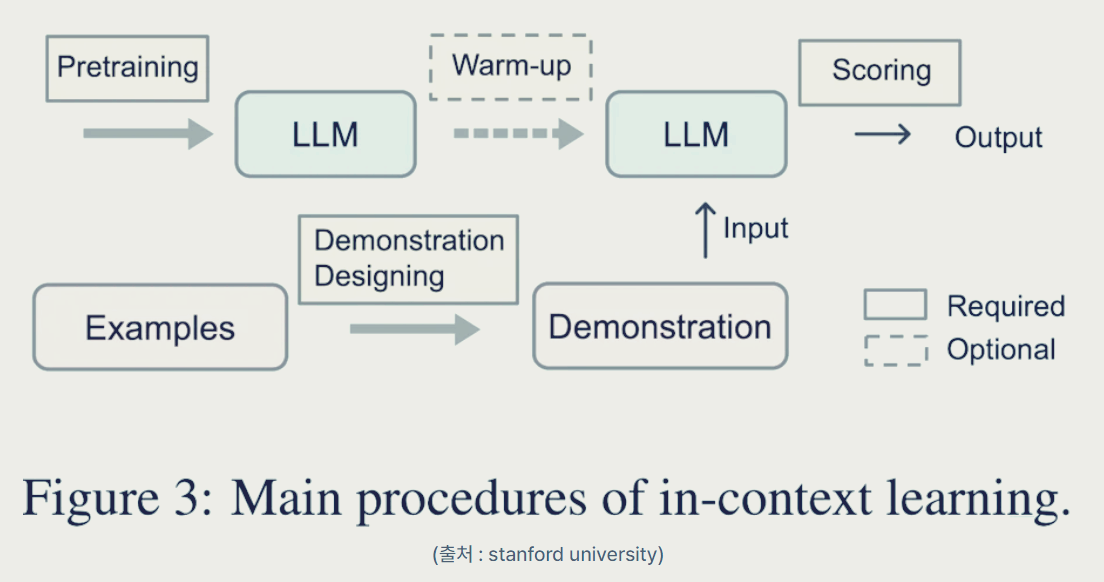

■ 인컨텍스트 러닝(In-Context Learning)의 방식

ICL은 기본적으로 입력 프롬프트에 제공된 데이터를 활용하여 새로운 작업을 수행하는 방식으로 이루어지며, 이는 크게 다음과 같은 과정으로 진행됨

1. 프롬프트 제공

- 사용자는 특정한 작업을 수행하도록 모델에게 요청하며, 프롬프트에는 다음과 같은 요소들이 포함될 수 있음

* 작업 설명(Task Description)

* 예제(Examples)

* 질문 또는 입력값(Query)

2. 모델이 패턴 학습

- 프롬프트 내 제공된 예제들을 바탕으로 모델은 패턴을 학습, 모델이 기존에 학습한 정보가 아닌 프롬프트 내에서 제공된 패턴을 인식하여 적용하는 것이 핵심

3. 결과 생성

- 모델은 학습한 패턴을 적용하여 주어진 입력값에 대한 결과를 생성

■ 인컨텍스트 러닝(In-Context Learning)의 주요 유형

1. Zero-shot Learning (제로샷 학습)

- 사용자가 예제 없이 작업 설명만을 제공하면, 모델은 기존에 학습한 일반적인 지식을 활용하여 문제를 해결함

- 예시:

질문: "사과는 어떤 색인가요?"

답변: "대부분의 사과는 빨간색이지만, 녹색이나 노란색도 있습니다."

2. One-shot Learning (원샷 학습)

- 단 하나의 예제를 제공하여 모델이 패턴을 학습하도록 유도함

- 예시:

예제: "서울은 대한민국의 수도입니다."

질문: "도쿄는 어느 나라의 수도인가요?"

답변: "일본의 수도입니다."

3. Few-shot Learning (퓨샷 학습)

- 여러 개의 예제를 제공하여 모델이 더 정확한 패턴을 인식하고 적용하도록 함

- 예시:

1+1 = 2

2+2 = 4

3+3 = ?

답변: 6

■ 인컨텍스트 러닝(In-Context Learning)의 장점

1. 추가 학습 불필요

- 기존 AI 모델들은 특정한 작업을 수행하기 위해 별도의 재학습이나 추가적인 파라미터 조정이 필요하지만, ICL은 훈련된 모델을 그대로 사용하면서 프롬프트만으로 새로운 작업을 수행할 수 있음

2. 높은 유연성

- 같은 모델을 활용하여 다양한 문제를 해결할 수 있음

- 프롬프트만 변경하면 번역, 문서 요약, 감정 분석, 텍스트 생성 등의 다양한 작업을 수행할 수 있음

3. 데이터 활용 최적화

- 모델이 훈련된 이후에도 새로운 데이터나 업무 프로세스를 반영할 수 있으며, 이를 통해 새로운 환경에서도 빠르게 적응할 수 있음

4. 비용 절감

- 모델을 재훈련하거나 새로운 데이터 세트를 구축하는 비용 없이 기존의 모델을 활용하여 새로운 문제를 해결할 수 있음

■ 인컨텍스트 러닝(In-Context Learning)의 단점

1. 성능 변동성

- 모델이 제공된 예제의 순서나 표현 방식에 민감하게 반응할 수 있음

- 동일한 예제를 제공하더라도 프롬프트를 어떻게 구성하느냐에 따라 결과가 달라질 수 있음

2. 컨텍스트 길이 제한

- LLM은 한 번에 처리할 수 있는 토큰 수(맥락 길이, Context Length)에 제한이 있음

- 예시를 너무 많이 제공하면 오히려 정보가 손실될 수 있음

3. 정확도 문제

- 훈련 데이터에서 본 적 없는 새로운 개념이나 패턴이 포함될 경우 부정확한 결과를 생성할 수 있음

- 특정한 작업에서 전문가 수준의 정밀한 답변을 기대하기 어려울 수 있음

4. 보안 및 편향 문제

- 모델이 학습한 데이터 내에 포함된 편향(Bias)이나 잘못된 정보가 그대로 반영될 수 있음

- 프롬프트를 조작하여 악의적인 결과를 유도할 가능성이 있음

■ 참고 자료

- https://blog.naver.com/auction_ai/223742070493

- https://blog.naver.com/auction_ai/223744643384

- https://aiheroes.ai/community/83

- https://jiogenes.github.io/%EB%85%BC%EB%AC%B8%EB%A6%AC%EB%B7%B0/2024/08/29/a-survey-on-icl.html

- https://blog.naver.com/aikidslab/223673135781

- https://kimhongsi.tistory.com/entry/GenAI-in-context-learning%EC%9D%B4%EB%9E%80-%EC%9E%A5%EC%A0%90-%EC%9B%90%EB%A6%AC-%EC%A0%81%EC%9A%A9-%EB%B6%84%EC%95%BC

- https://hexists.tistory.com/249

- https://www.lakera.ai/blog/what-is-in-context-learning

- https://www.prompthub.us/blog/in-context-learning-guide

- https://www.linkedin.com/pulse/whats-in-context-learning-deep-why-its-so-cool-yacine-mahdid--lvgne

'AI' 카테고리의 다른 글

| (AI) 2025년 10월 대화형 AI 검색 트렌드 분석, 챗GPT의 압도적 우위 (0) | 2025.11.04 |

|---|---|

| 쇼핑 에이전틱 AI(agentic AI)에 대한 요약 (0) | 2025.10.26 |

| (AI) 피지컬 AI(Physical AI) 개념 요약, 현황 및 시사점 (0) | 2025.10.13 |

| (동향) 국내 주요 IT 기업의 AI 개발 및 제휴 관련 현황 (0) | 2025.02.24 |

댓글